Deel 2 – Staat er big data op het recept?

Vorige keer heb ik ons ‘slimme software’ team geïntroduceerd.

Als we het hebben over “artificial intelligence”, dan wordt snel de link met “big data” gelegd. Zijn die twee echt onlosmakelijk verbonden? En hoeveel data heb je dan nodig? Daar ga ik in deze aflevering op in.

Als consument komen we dagelijks in aanraking met AI-toepassingen. Denk aan personal assistants zoals Amazon Alexa en Google Home. Het feit dat je tegen zo’n apparaat kunt praten – in normale mensentaal – en dat het dan (meestal) ook doet wat je het vraagt– bewijst hoeveel je kunt bereiken met machine learning. En ja, om een machine te leren menselijke spraak te begrijpen heb je enorm veel data nodig.

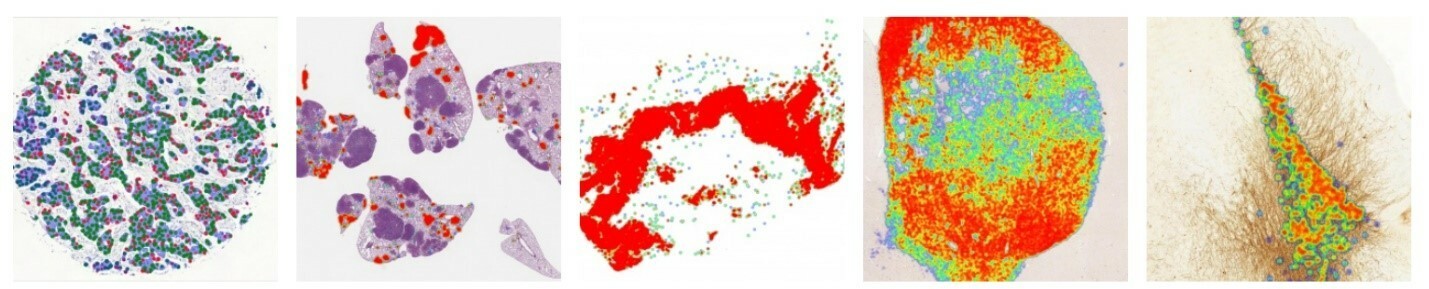

Ook in de medische wereld zien we een enorme opmars van AI. Zo zijn er in de pathologie al bepaalde taken waarbij AI de prestaties van artsen overtreft, bijvoorbeeld als het gaat om het herkennen van geïsoleerde kankercellen op scans.

Toepassingen zoals deze zijn enkel mogelijk doordat de betreffende software getraind is met héél veel data: miljoenen scans. Misschien is het wel daarom, dat organisaties het moeilijk vinden om de toepasbaarheid van AI in de eigen processen te vinden. De lat wordt direct heel hoog gelegd. Dan moet je ineens én een briljant idee én een stuwmeer vol data hebben.

Nu hebben organisaties vaak veel meer data dan door een mens te overzien is, zeker als je nagaat wat er in het primaire proces allemaal digitaal wordt vastgelegd. Als we echter kijken naar secundaire processen, zoals klachtenafhandeling of incidentmanagement, dan hebben we het over aantallen per jaar die variëren van tientallen tot tienduizend-tallen –geen miljoenen of miljarden.

Veel te weinig!

Of toch niet?

Als je de nadruk legt op het slimmer maken van software – om professionals beter te ondersteunen in hun werk – dan heb je zelf niet per se heel veel data nodig. Veel data is vooral nodig als je zelf ‘from scratch’ machine learning modellen wilt gaan trainen; bijvoorbeeld om een voorspellingsmodel te maken wat heel specifiek is voor jouw organisatie. Je hebt echter niet voor ieder probleem een volledig zelf getraind model nodig. Voor veel toepassingen kom je een heel eind door te kiezen uit het grote aanbod van al bestaande modellen – en die op een zinvolle manier te verweven in software. Denk bijvoorbeeld aan:

- Tekst analyseren, samenvatten of vertalen

- Opsporen van dubbele documenten of sterk overeenkomende incidentmeldingen

- Clusters en correlaties zoeken

Wil dat nu zeggen dat we met ons team altijd weg zullen blijven van het trainen van modellen?

Nee. Maar onze eerste voorkeur zal wel altijd uitgaan naar het toepassen van bestaande bouwstenen – want daarmee helpen we je het snelst vooruit.

En wil dat nu zeggen dat we wég blijven van big data?

Nee. Wat we zeggen is: ook als er níet veel data is, kunnen we je leven gemakkelijker maken.

Als er wél veel data is, opent dat de deur naar nog meer mogelijkheden.

Daar kom ik een volgend deel van deze blog vast nog eens op terug!

Lees nu ook deel 3: Tekst is de parel!